Edison 发表于 2012-2-11 20:41

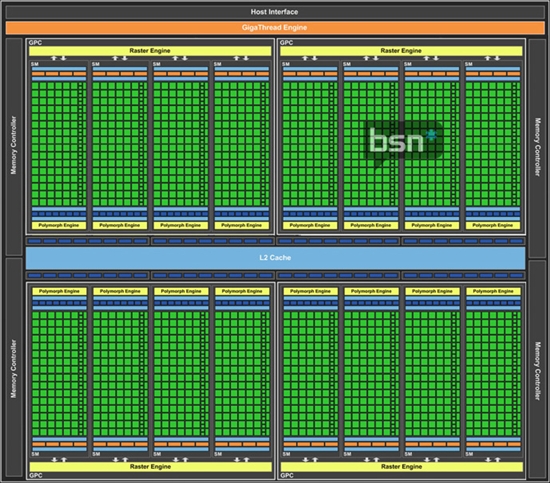

你对 Tesla 和 Fermi 的架构认识不够清楚。

GT200 可以让所有的 cuda core 再加上 SFU 实现 8 cuda co ...

Edison 发表于 2012-2-11 21:06

NVIDIA 对 GPUBench 的 RCP 函数计算一直有些特殊的优化,所以不要指望拿 GPUbench 出来的 rcp 测试结果作为 ...

NV核心单精度浮点运算的计算公式是流处理器频率*3*流处理器数量,当初GTX280的规格是240sp,流处理器频率1296M,算的单精度浮点运算为0.933T,与标称相符。用这种方法算得580单精度浮点运算是2.372T,和标称不符

Edison 发表于 2012-2-11 21:47 修正理论值计算方式后,足以让你的斜率截然不同。

Edison 发表于 2012-2-12 12:55

Tesla 20 的 dual-issue 只有在常见算术指令+MUL 的情况下才能实现,例如 MAD+MUL、ADD+MUL、MUL+MUL,它无 ...

。oh my ladygaga!

。oh my ladygaga!| 欢迎光临 POPPUR爱换 (https://we.poppur.com/) | Powered by Discuz! X3.4 |